Value Function

State value function

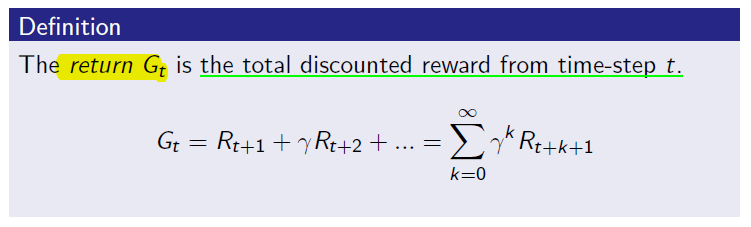

여기서의 감마는 Discount Factor 값.

감마 값은 할인 인자 0~1사이 값. 미래 보상의 현재가치를 나타냄.

0에 가까우면 근시적인 평가. 1에 가까우면 원시적인 평가.

Return : 한 episode 안에 agent가 행한 action의 할인된 reward의 총 합.

return의 expectation이 State value function.

아래와 같이 표현.

MRP의 State value function은 시작된 어떤 상태 s 의 기대 가치이다.

agent가 다음 state로 가기위해서는 다음 stage들의 가치를 보고 높은 가치를 가진 state로 이동한다.

그렇기 때문에 value function이 상당히 중요해지고 효율적이고 정확한 value function을 구할 방법이 중요한 문제가 된다.

value function을 계산하기 위해 agent가 일정한 Policy에 의해 행동을 결정하도록 하는 것이다.

각 policy 마다 value function 값이 변화할 수 있기때문에 value function 값을 최대로 하는 policy를 찾는 것이 가능해진다.

policy에 따른 value function은 아래와 같다.

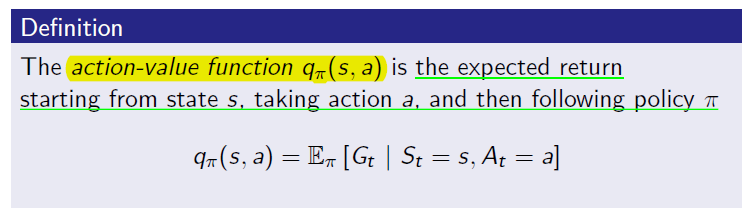

Action value function

action이란 어떤 state에서 agent가 취할수 있는 행동이다.

보통은 state마다 취할 action은 모두 같다.

state의 가치는 어떤 action을 취했는지에 따라 달라지는 reward에 대한 정보도 포함.

agent는 다음 action을 다음 state의 value function을 가지고 선택해야하는데 그러기 위해서 state들의 모든 정보를 알아야하고 가기위해 해야할 일도 알아야한다.

그 모든 정보를 담은 value function이 action에 대한 value function인 action value function이다.

이 function은 다음에 취할 action에 대한 판단을 가능하게한다. state로 이동할 확률을 알 필요가 없어진다.

state s에서 action a를 취할 경우에 받을 return에 대한 기대치. 어떤 행동을 했을때의 기대치.

이 값을 Q-value라고 부르기도 하며, Q-learning이나 Deep Q-network에 포함된 Q 가 이것을 나타낸다.

'{Programing} > {AI}' 카테고리의 다른 글

| 벌 수 있을까? 강화학습으로 주식 자동 투자 해보기 - EP.0 (0) | 2023.02.04 |

|---|---|

| Fundamental of Reinforcement Learning 공부 정리!!(5) (0) | 2017.11.05 |

| Fundamental of Reinforcement Learning 공부 정리!!(3) (0) | 2017.09.25 |

| Fundamental of Reinforcement Learning 공부 정리!!(2) (0) | 2017.09.25 |

| Fundamental of Reinforcement Learning 공부 정리!!(1) (0) | 2017.09.25 |